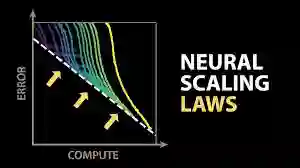

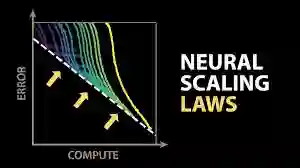

Leggi di Scalabilità dell'AI

Dario Amodei di Anthropic spiega come l'aumento delle dimensioni dei modelli AI, dei dati e delle risorse computazionali migliori le prestazioni. Le leggi di scalabilità sono state osservate in vari domini. Tuttavia, ci sono potenziali limiti futuri da considerare.

Le leggi di scalabilità nell'intelligenza artificiale (AI) indicano che incrementando le dimensioni dei modelli, i dati disponibili e le risorse computazionali, si ottengono miglioramenti significativi nelle prestazioni. Questa idea, sostenuta da Dario Amodei, CEO di Anthropic, deriva dalla sua esperienza diretta nel settore, iniziata circa dieci anni fa con i suoi primi studi sul riconoscimento vocale.

Amodei notò già all'epoca che modelli più grandi e dataset più ampi miglioravano sensibilmente la qualità delle prestazioni. Inizialmente riteneva che tale fenomeno fosse limitato a settori specifici come il riconoscimento vocale; tuttavia, l'emergere di GPT-1 nel 2017 cambiò radicalmente la sua visione, dimostrando come anche il linguaggio potesse beneficiare enormemente di approcci simili.

Secondo Amodei, le leggi di scalabilità hanno ormai trovato conferma in molteplici ambiti oltre il linguaggio, estendendosi anche a immagini, video e diverse altre tipologie di dati. Il parallelo proposto da Amodei è quello di una reazione chimica: per ottenere risultati ottimali, tutti gli ingredienti—dimensioni della rete, volume di dati e tempo di addestramento—devono essere aumentati proporzionalmente.

Una questione centrale affrontata da Amodei riguarda il motivo per cui modelli più ampi e dataset più vasti portano a risultati migliori. La risposta proposta è che reti neurali più grandi hanno la capacità di cogliere schemi e correlazioni sempre più complessi e meno frequenti, consentendo così prestazioni superiori e più accurate.

Nonostante gli attuali successi, Amodei sottolinea possibili limiti futuri: la disponibilità limitata di nuovi dati di qualità, vincoli computazionali e la sostenibilità a lungo termine del processo di scalabilità. Nonostante queste sfide, la traiettoria attuale indica che i modelli di intelligenza artificiale stanno rapidamente raggiungendo livelli di competenza senza precedenti. Recenti modelli hanno infatti mostrato risultati impressionanti in compiti complessi, quali la programmazione e la risoluzione di problemi scientifici avanzati.

L'evoluzione continua dell'AI potrebbe presto generare modelli capaci di superare le capacità umane in molti ambiti, sebbene, secondo Amodei, i limiti definitivi della scalabilità restino ancora da esplorare.

L'immagine mostra il concetto delle leggi di scalabilità (scaling laws) applicate ai modelli di intelligenza artificiale. L'asse orizzontale rappresenta il potere computazionale ("compute"), mentre quello verticale indica l'errore commesso dai modelli nel risolvere un determinato compito. La linea tratteggiata bianca definisce la soglia ideale di prestazione raggiungibile, cioè il limite teorico minimo dell'errore. Sopra questa linea compaiono diverse curve colorate, ognuna corrispondente a un singolo modello o configurazione. Tali curve mostrano che inizialmente, aumentando le risorse computazionali, si ottiene un netto miglioramento delle performance con una rapida riduzione dell'errore. Tuttavia, dopo una certa soglia, ogni curva rallenta progressivamente e tende a stabilizzarsi, indicando un limite massimo di prestazioni oltre il quale ulteriori aumenti di risorse portano solo minimi miglioramenti. Questo significa che per continuare a migliorare significativamente occorre passare a modelli più grandi e complessi, che consentono di avvicinarsi ulteriormente al limite ideale di prestazione definito dalla linea tratteggiata.